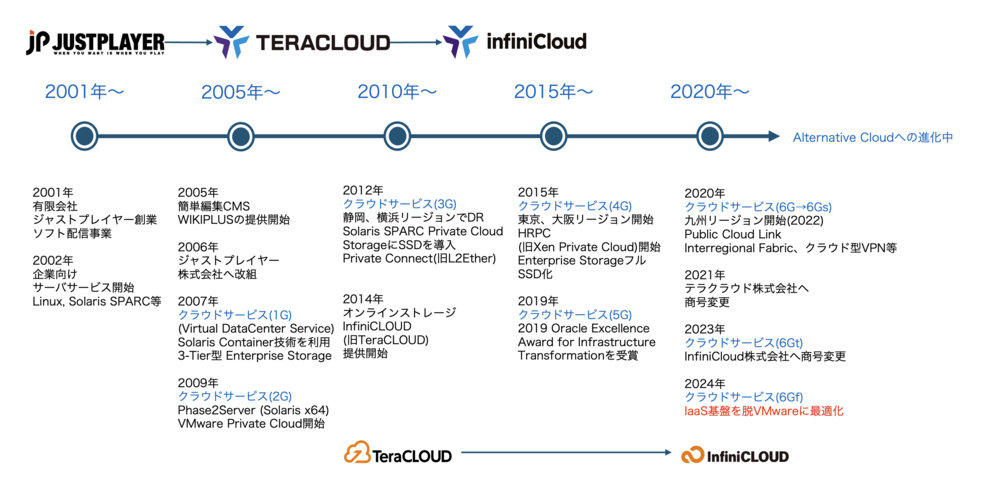

InfiniCloudのクラウド・ファブリック(プライベートクラウド × ストレージ × ネットワーク)は、2007年に提供を開始した「Virtual Data Center Service(仮想データセンターサービス)」を起点に、ミッションクリティカルなニーズに応える進化を続けてきました。

このTechストーリーは、当社の技術の進化と共に、プライベートクラウドならではの強みや、ITインフラストラクチャを形作る技術の裏側に触れる読み物として、技術者やITプロフェショナルの方々にお楽しみいただけるコンテンツです。

シリーズ: InfiniCloudの「クラウドファブリック」はどう進化してきたのか?