InfiniCloud® AI

目的によって選ぶ導入モデル

利用シーンや規模に応じて、いくつかの導入モデルを用意しています。

主な導入形態は次の3つです。

- オンプレミス導入モデル

- データセンター・クラウド事業者向け OEM モデル

- クラウド版(現在準備中)

本ページでは、それぞれの導入形態と、GPU/VRAMに応じた推奨構成、モデルラインナップについて説明します。

導入形態

オンプレミスモデル

InfiniCloud® AI の基本的な導入形態は、国内 SIer・パートナー企業経由によるオンプレミス導入です。

- サーバーのハードウェアは SIer側でご提案・調達。

- お客様のデータセンター・ラック内に設置され、完全に自社管理のネットワーク内で運用可能

- インストール・初期設定・基本的な運用設計については、パートナー SIer と連携しながら InfiniCloud が技術支援を行う

「どの GPU を選べばよいか分からない」「既に購入済みのサーバーで動かしたい」といったご相談も含め、まずは提携するSIer、またはInfiniCloudまでお問い合わせください。

※現在、InfiniCloudでは、InfiniCloud AIを組み込んでシステム販売を行いたいシステムインテグレーターのパートナーを募集中です。詳しくはお問い合わせください。

参考≫ お知らせ一覧/【プレスリリース】高性能オンプレミスAI「InfiniCloud® AI」のOEM技術提供開始。データセンター事業者およびSIer向けに

OEM/ODM データセンター事業者向け専用モデル

データセンター・クラウド事業者向けには、OEM 形態での提供が可能です。いずれも自社ブランド(あるいは当社ブランド)にて、Private AIサービスを行うことが可能です。

- 自社データセンター内のGPU基盤に、InfiniCloud AIを用意したい場合

- 自社データセンターに、InfiniCloud AIに適合するGPU基盤を構築したい場合。

参考≫ お知らせ一覧/【プレスリリース】高性能オンプレミスAI「InfiniCloud® AI」のOEM技術提供開始。データセンター事業者およびSIer向けに

クラウド版(準備中)

「まずはすぐに試してみたい」「サーバーの管理はしたくない」「閉域網で利用したい」「オンプレ導入前に PoC を行いたい」といったニーズ向けに、クラウド版 InfiniCloud AI も提供予定です。

- 初期投資無しで PoCから開始可能。

- 自社 SaaS のバックエンドとして LLMaaS 的に利用する用途にも適しています

参考≫ お知らせ一覧/【プレスリリース】InfiniCloud、さくらインターネットとの協業により、AI基盤提供に向けた基本合意を締結。企業向けに外部に情報が漏洩しない閉域網に対応。

ライセンスモデル

InfiniCloud® AIのソフトウェアライセンスは、GPU 単位のライセンスを基本としています。

- 物理 GPU ではなく、InfiniCloud AIに割り当てたGPU個数でライセンス費用が変わります。

- 例:仮想化基盤のGPUパススルー機能を使い、8枚GPUを搭載したハードウェアに、GPUを「1枚」だけ見せた場合は、1ライセンスとなります。

- ライセンス価格はオープンプライスで、月額、年額プランがあります。

導入規模やサポート内容に応じて SIer・OEM パートナーとの個別見積もりとなります。

導入後の性能と、サポート品質を確実にするため、InfiniCloud® AI は 動作検証済みハードウェアとの一体提供を基本方針としています。現時点では、エンドユーザーのサーバーへの、「ソフトウェア単体導入」はお受けしておらず、SIer / OEM パートナーと連携した「構成設計+ハードウェア+ソフトウェア」のパッケージとしてご提供しています。

推奨動作環境のスペック(GPU、VRAMなどの対象範囲)

InfiniCloudの推奨する動作環境は、扱う LLM のパラメタ数や、どの目的、どの機能を使うかによって異なります。

ここでは、代表的な GPU と VRAM 構成ごとの 目安 を示します。

対応 GPU の例

- NVIDIA GPU

- H100 / H200 シリーズ

- B100 / B200 シリーズ

- RTX Pro 6000 Blackwell シリーズ

- L40S/L4 シリーズ (※Fine Tune機能が利用できません)

- AMD

- Instinct MI300X … 対応予定(準備が整い次第検証開始)

一般にLLMを動作させる為のGPU性能は、解答速度(tokens/sec)に影響します。

- GPU性能が高いと、解答速度が速い。

- GPU性能が高いと、並列的に回答しても、速度劣化が少ない。

- GPUのメモリ帯域が広いと、解答速度が速い。大きなモデルでも対応可能となる。

- LLMのパラメタ数が少ないと解答速度が速い。

- 複数のGPUを利用すると、その分解答速度も上がり、同時並列的な速度が上がる。

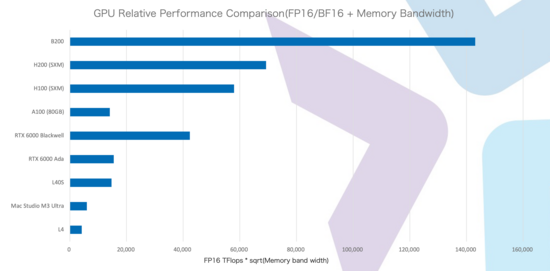

下記は、InfiniCloud AIにおけるベンチマークです。概ね、BF16でのTFlops(速度)x√メモリ帯域幅となっています。

これらの性能グラフは一例であり、当社の「InfiniCloud AI」を実行させるための環境は「このような傾向がある」と示したものです。

実際のサポート状況はバージョン・時期により変わるため、詳細は都度お問い合わせください。

VRAM サイズ別の機能レベル(ベースモデル:GPT-OSS 20B の例)

以下は、GPT-OSS 20B クラスのモデルを前提としたときの一例です(あくまで目安です)。

| VRAM 構成 | 推論のみ | FineTune | 同時セッション目安 | 想定シナリオ |

|---|---|---|---|---|

| 24〜48GB | ○ | × | 少数ユーザー(同時利用4〜8人程度) | PoC。部内専用Private AI |

| 80GB~96GB | ○ | ○(余裕は少なめ) | 小〜中規模(〜数十人) | 本番運用可。同時接続を増やし、ナレッジ増で余裕が減る |

| 2×80/96GB(マルチGPU) | ◎ | ◎ | 中〜大規模(数十〜数百人) | FineTune と高セッション数を両立した構成。 |

24〜48GB クラスでは、ベースモデル20Bパラメタ程度の推論自体は可能ですが、FineTune 機能にはほとんど余裕がなく、事実上、InfiniCloud AIの「機能縮退版」としての利用が中心となります。この場合、上位のインフラストラクチャで同様のベースモデルを利用し、Fine Tune情報をフィードバックすることで「推論機」として利用することは可能です。

80/96GB クラス(H100 80GBや、RTX Pro 6000 Blackwell)では、20Bパラメタ程度のランゲージモデルの本番利用とLoRAベースの FineTune が可能ですが、大規模なナレッジ投入や高セッション数を考える場合は、少々、性能が足りなくなります。

2×80GB 以上の構成では、FineTune と高頻度の推論の両方に十分な余裕があり、LLMaaS 的な使い方や大規模組織での共用にも対応しやすくなります。

一般にGPUのメモリ量は、パラメタ数の大きいLLMを動作させたり、ファインチューン用メモリの余剰にも役立ち、並列性能にも貢献します。

大型LLMは高性能ですが、その分、メモリ専有量が多く、回答速度も遅くなり、ファインチューンの勾配がつきにくい(ファインチューン学習の効果が現れにくく、ベースモデルが持っている元の知識に回答が引っ張られやすい)傾向があります。

実際は、ニーズに合わせて、モデル種別やプロンプト長、ナレッジ量によって変動します。詳細なキャパシティ・プランニングについては、個別にご相談ください。

InfiniCloud AI Appliance Model S(サブセットモデル)

「InfiniCloud AI Appliance」は、小規模環境向けとして、通常の1Uサーバーと同じぐらいの消費電力、「オンプレミス」で利用できるアプライアンス製品です。

完全に隔離された社内ネットワークへ設置可能。学習情報、会話情報など、一切、サーバー外には送信しない設計のため、セキュリティ要件が極めて高い要件にも対応可能です。

ただし、InfiniCloud AIのサブセット機能版がインストールされており、ファインチューンなどの機能はありません。

低消費電力設計

InfiniCloud AIは、GPUへの負荷(VRAM利用量)が大きくならないように、コーパスデータベースの細分化を行い、省電力で実現するための設計をしています。

- GPU搭載ラックマウント型サーバー

- InfiniCloud® HV Xen® Type / InfiniCloud AIのプリインストール

- AI用仮想マシン構築・モデル導入済み

- FineTune engineは非搭載です。

モデルS「アプライアンスハードウェア」

モデルSは実効電力がおよそ600W以下(概ね400W〜500Wの範囲)。空冷で1Uサイズ。日本基準の一般的なデータセンターにそのまま設置可能なアプライアンスモデルです。

低消費電力を実現するため、InfiniCloud AIのサブセットとなっていますが、購入したその日から利用することが可能です。

CPU、メモリ、HCI用のSSD容量、構成に関しては、変更が可能です。

| モデルSハードウェア機能 | |

|---|---|

| 型番 | モデルS:AG-PRIE-K63 |

| 筐体サイズ | 1U Chassis 438 mm (W) x 43.05 mm (H) x 800/850 mm (D) |

| 電源 | 2系統 1100W (標準セットの実効電力600W未満) |

| ネットワーク | 2系統 SFP28〜 ※別途、適切なトランシーバーを入れることで様々なネットワークに接続可能です |

| ストレージ容量 | Enterprise NVMe SSD 7.68TB〜 |

| ベースモデル | KEYAKIJP KVR110F1A-G1 |

| CPU | AMD EPYC 9334(32Core) |

| 搭載メモリ | 384GB |

| GPU | NVIDIA L4 24GB ※L40S 48GBに拡張することで、回答速度、並列回答機能が向上します |

| AIオーケストレーション | InfiniCloud AI Ver 1.1 サブセット版 ※モデルSはファインチューニングが動作しません。 |

| プリインストールハイパバイザ | InfiniCloud HV Xenタイプ |

| 備考 | InfiniCloud PCAの1ノードとして扱うことも可能。スペックを揃える必要があります。 ※ただし、InfiniCloud AIの入っている仮想マシンはマイグレーションできません。 |

InfiniCloud AI Ver1.1 (Shiraito) インストールソフトウェア

モデルSはShiraitoシリーズの下記のソフトウェア、モデルのインストールが行われています。

| AI オーケストレーション | InfiniCloud AI Ver 1.1 (Codename:Shiraito) |

|---|---|

| UI(ユーザーインターフェイス) | Shiraito-Chatbot(frontend/backend) |

| API | Shiraito-APIv1 OpenAI準互換API: /v1/health /v1/model Shiraitoの知能ドメインの選択が可能 /v1/chat/completions 単純な推論 /v1/assistants 会話型の推論 |

| 知能ドメイン管理(RAG) | Shiraito-RAG-manager(知識の投入と管理のみ) |

| 知能ドメイン管理(FT) | なし。モデルSでは、Shiraito-ftが未搭載です。 |

| InfiniCloud llm ツールキット | ドキュメントの細分化、ファインチューン機能の一部 |

| LLM Server Manager | Shiraito-LLM-sm(llama-server版) |

| 対応ランゲージモデル | 下記のランゲージモデル群は動作確認済みです。 OpenAI GPT OSS 20B Alibaba Qwen3 東京科学大学 情報理工学院 Swallow ※それぞれのランゲージモデルは、配布元のライセンスに従うものとなります。 |

| ミドルウェアなど | Python 3.12 FastAPI LangChain PyTorch Huggingface transformers |