知識の投入

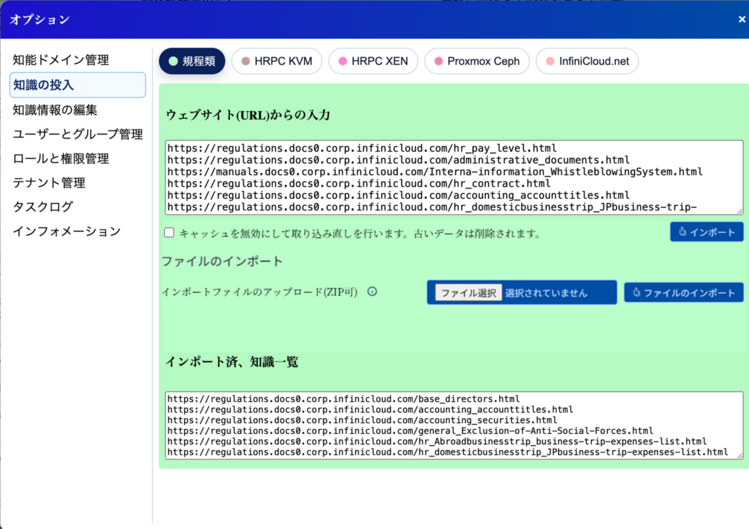

タブ・インターフェイス

知識の投入はタブ・インターフェイスを持ち、知識毎に切り替えることができます。

間違って異なる知能ドメインに、異なるデータを入力すると、意図しないユーザーに意図しない回答を返すことになり、場合によっては取り返しがつかない情報漏洩を起こすことになります。そのため、間違いにくいように、背景にカラーパレットで選択された色を指定しています。

タブが多くなると右上にプルダウンが現れ、選択できるようになります。

ウェブサイト(URL)からの入力

社内ウェブサイトや、自社サイトのオンラインマニュアルなど、Web上のページをまとめて取り込み、知識として利用できるようにするための機能です。

何ができるか

- 指定した URL から HTML を取得し、テキストと構造(見出し等)を抽出

- ページ内容を適切なサイズのチャンクに分割

- ベクタ化(Embedding)して、検索可能な知識としてインデックス化

主な操作手順

- 最初に間違えずに知能ドメインを選択しておきます。

- 「ウェブサイト(URL)からの入力」セクションを開きます。

- 取り込みたいページの URL を入力します。

- サイト内の複数ページをクローリングする設定がある場合は、必要に応じてURLを列挙します。

- 「インポート開始」ボタンを押すと、取得 → 解析 → インデックス作成まで自動で進みます。

Tutor向け補足知識

HTML 由来のデータは、見出し構造が保持されやすく、最も質の高いRAGデータになります。

ログインが必要なページや、社内VPN内部のみで見られるページは、別途HTMLをエクスポートして「ファイルのインポート」を利用する形が適切です。広告・フッタなどノイズの多いページは、InfiniCloud AIの機能で自動的にメインコンテンツのみを切り出しますが、どうしてもうまく行かない場合は、事前にコンテンツ部分だけを切り出したURLを用意すると、検索精度が向上します。

ファイルのインポート

目的

- ローカルに保存されているマニュアルや規程集などを、一括で知識として取り込むための機能です。

何ができるか

- ローカルファイル(PDF / Markdown / テキストなど)をアップロード

- 自動的にテキスト抽出・チャンク分割・ベクタ化を実行

- 知能ドメインに紐づく知識として登録

| 種別 | 拡張子例 | 備考 |

|---|---|---|

| レイアウト次第で構造が崩れる場合あり | ||

| Wordファイル | .docx | ヘッダーなどがきちんと作られていれば、構造化されたまま読むことができる |

| Markdown | .md | 見出し構造が保たれやすく推奨 |

| テキスト | .txt | シンプルな文章であれば問題なし |

| HTMLファイル | .html .htm | Webと同様、もっとも構造化された情報として扱える |

InfiniCloud AIはDocument Semantics(文章構造)を情報として解釈するため、HTML情報のようにHタグやテーブル、リストなどが明確な情報の方が、より構造に合わせた学習を行います。

インポートボタンを押す

URLの入力の時は「インポート」ボタン、ファイルのアップロードの場合は「アップロード&インポート」ボタンを押します。

インポートが始まると、URLの時はページを参照に行き、内部にキャッシュします。以前に比べて新しくなった場合は、キャッシュと比較し、自動的に新しい方を取り込みます。

ファイルの場合はアップロードが始まり、ZIPの場合は展開します。

展開されたデータを見て、ファイルの中のゴミ(例えばウェブサイトのナビゲーションなどはAIの学習にとってはゴミ情報です)を抜き出し、覚えるべき情報だけをなるべくチャンク(短冊状)に分けてベクタDBに投入を行います。