仮想マシンの新規作成方法

このページでは、Proxmox VEを使用して、HRPC KVM版上で仮想マシン(VM)の新規作成を行う方法をご案内しています。

ユーザーはアップロードされたISOファイルを利用し、CPU、ストレージ、ネットワークなどの項目を設定することで、環境や用途に合った仮想マシンを作成することができます。ここでは例示として、Linuxのセットアップを行っています。

仮想マシンを新規作成する

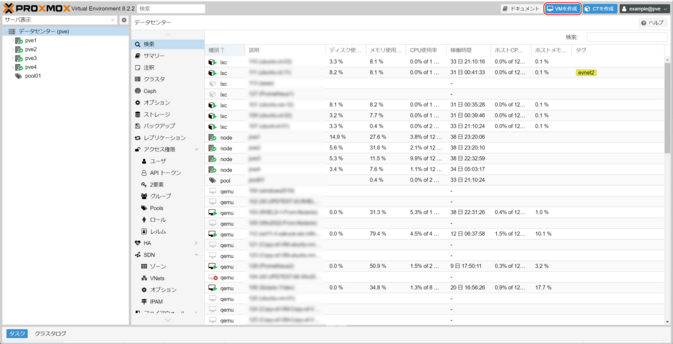

1.新規作成ボタンをクリックする

HOME画面の「VMを作成」をクリックします。

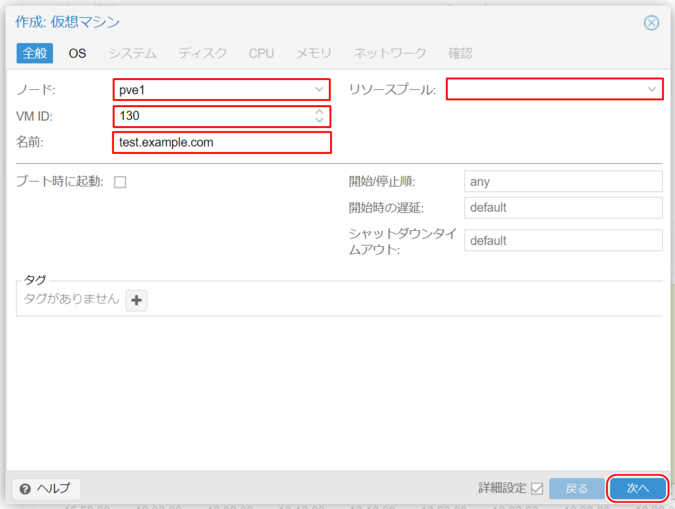

2.全般設定

- ノード

- 仮想マシンを作成するノード(物理サーバー)を選択します。

- VM ID

- Proxmox VE内でVMを識別するための一意の番号が自動で割り振られます。初期値は100から順次割り振られていきます。

- 名前

- 仮想マシンの名前を入力します。ここではホスト名を推奨しています。

- リソースプール

- 仮想マシンを作成するリソースプール(VMの論理グループ)を選択します(任意)

- 「次へ」をクリックします。

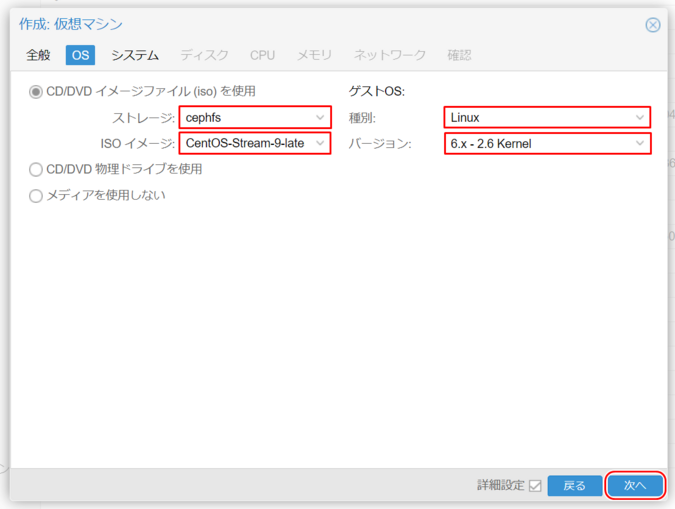

3.OS設定

- 「CD/DVD イメージファイル (iso) を使用」

- 「ストレージ」から、ISOファイルをアップロードしたファイルシステムを選択します。HCI設計のサーバでは「cephfs」が、3Tier型の場合は、設定されたBSFかESFの、NFS名が利用されています。

- ISOイメージ

- ISOイメージを選択します。ISOイメージは、インストールするゲストOSに適したものを選択します。

- ゲストOS

- インストールするゲストOSの種別とバージョンを選択します。

- 参考≫ サポート情報/マニュアル/HRPC - Proxmox VE/仮想マシンの新規作成/対応するゲストOS一覧

- 「次へ」をクリックします。

このときに選択するISOイメージは、ユーザ自身がアップロードしたものを利用出来ます。詳しくは、サポート情報/マニュアル/HRPC - Proxmox VE/その他/isoイメージのアップロード方法を参照してください。

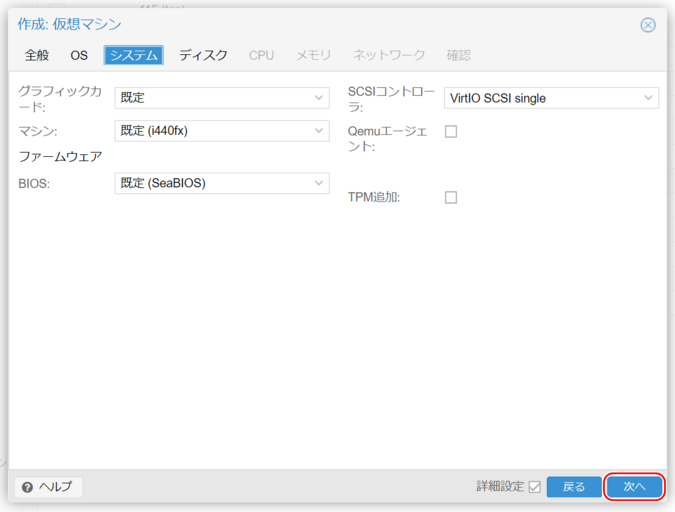

4.システム設定

- グラフィックカード

- 規定

- マシン

- 規定(i440fx)※特に変更する必要はありません

- ファームウェア BIOS

- 規定(SeaBIOS)、あるいはOVMF。

- SCSIコントローラ

- デフォルトの「VirtIO SCSI Single」。参考≫ SCSIコントローラについて

- Qemuエージェント

- Qemu-guest-agent(QEMUゲストエージェント)をインストールする予定の場合、チェックボックスにチェックを入れます。

- TPM追加

- Windows11や、Windows Server 2022以降のOSを利用する時はチェックが必要です。

- 「次へ」をクリックします。

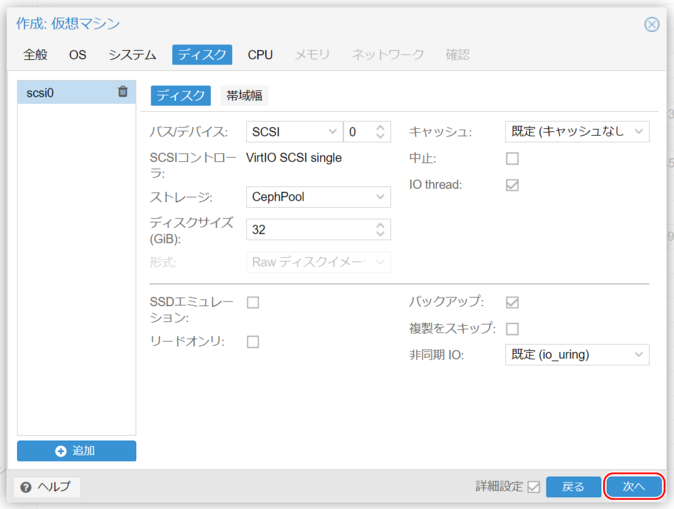

5.ディスク設定

仮想ディスクの設定をします。ここではディスクのコントローラ(バス/デバイス)とそこに繋がる仮想ディスクを設定します。

- バス/デバイス

- IDE:仮想ディスクを4台まで利用が可能です。ほぼ全てのOSがサポートします。

- SATA:仮想ディスクを6台まで利用が可能です。物理ハードウェアとの互換性はこれが一番高くなります。

- SCSI:システム設定で選んだSCSIコントローラに接続します。VirtIO SCSI、あるいはVirtIO SCSI Singleになっているとき、もっとも高速にディスクアクセスが可能になりますが、VirtIOドライバが入ったOSでないとOSのインストールができません。この様な場合は、OSを一旦、別の方式でインストールし、VirtIOドライバをゲストOSにインストールした後、変更する事になります。

- 参考≫ ディスクコントローラについて

- SCSIコントローラ

- 前節で設定したSCSIコントローラが記載されています。VirtIO SCSI Single、あるいはVirtIO SCSIが設定されています。

- 参考≫ SCSIコントローラについて

- ストレージ

- HCIモデルの場合はcephpoolとなります。

- IaR、あるいは単に独立ストレージの場合はicsN。

- 3Tier型の場合はesfNなどが接続されています。

- その他、local、cephfsは、isoファイルや、ovf import用のストレージエリアです。

- ディスクサイズ(GiB)

- 必要なディスクのサイズを指定してください。

- esfNを選んだ場合は、仮想ディスクの形式を選ぶ必要があります。QEMU形式(qcow2)はスナップショットの取得(ただし制限あり)が可能なため、特に事情が無い限りはqcow2にしておくことをお薦めします。rawを選ぶことで高速なアクセスが可能です。

- キャッシュ

- データ整合性が最重要である場合はdirectsyncを選び、パフォーマンスを優先する場合はWrite Backを選びます。リードのみキャッシュしたい場合はwrite throughを選びます。

- 参考≫ ディスクキャッシュについて

- 中止(discard)

- ストレージに対し、削除して不要になった領域を「Discard(破棄)」させます。ゲストOSによっては、SSDエミュレーションする必要がある場合があります。

- 参考≫ TRIM(discard)について

- IO thread

- IOスレッドを有効にすると、VirtIO SCSIなどを利用する際、ディスクの書き込みの実際の処理を、「親OSの」メインスレッドとは別のスレッドで扱うようになります。

- 参考≫ IO Threadについて

- 「次へ」をクリックします。

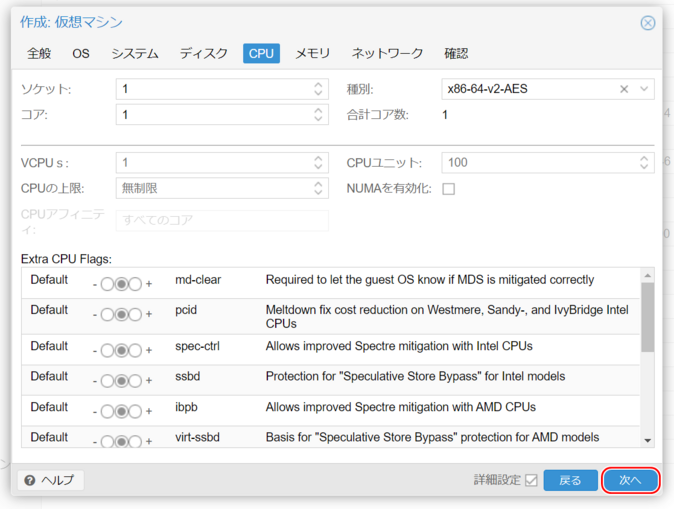

6.CPU設定

- ソケット

- ゲストOSに対して、複数ソケットのようにみせることができます。通常は1で構いませんが、ソケット数を複数割り充てる必要があるライセンス形態のソフトウェアを利用する時に指定します。

- コア

- 仮想マシンのコア数を指定します。合計のコア数はソケット数xコア数で決まります。ソケットとコアの配分は、仮想マシンの速度には影響しません。従って、CPUパワーが必要なときは、コア数を増やすことになります。

- 種別

- 仮想OSにみせるCPUタイプを表します。通常のOSでは「x86-64-v2-AES」のままで構いません。

- 参考≫ CPUについて

- 「次へ」をクリックします。

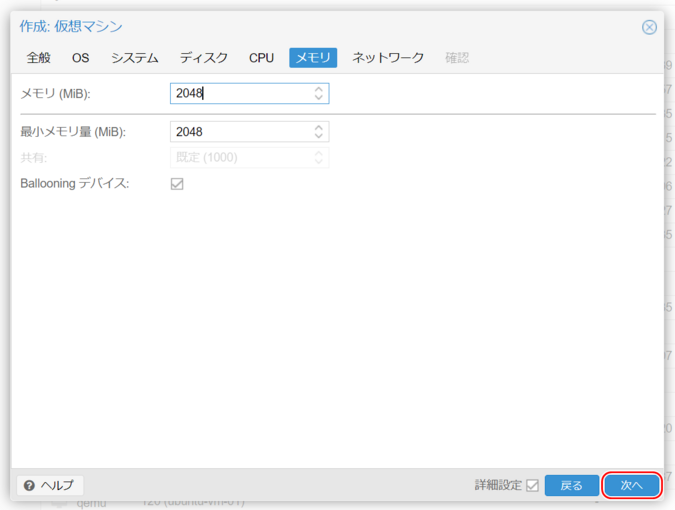

7.メモリ設定

- メモリ(MiB)、最小メモリ量(MiB)

- 必要なメモリ量を設定します。通常は同じ値を入れます。

- Ballooningデバイス

- チェックを外します。

- 参考≫ KVMのメモリ管理とBallooningドライバ

- 「次へ」をクリックします。

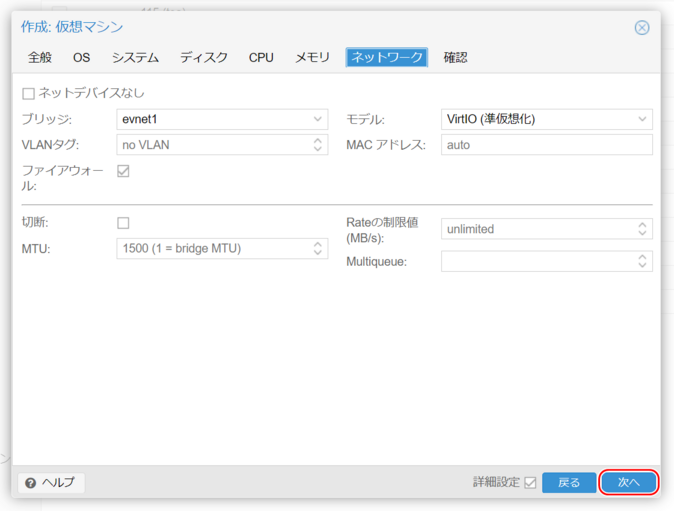

8.ネットワーク設定

- ブリッジ

- VNS名のブリッジが設定されています。YCN-LAN0の場合、YCN_LAN0となっていますので、ご注意ください。

- VLANタグ

- no VLANのままとしておいてください。

- モデル

- 通常、VirtIOを設定します。

- 「次へ」をクリックします。

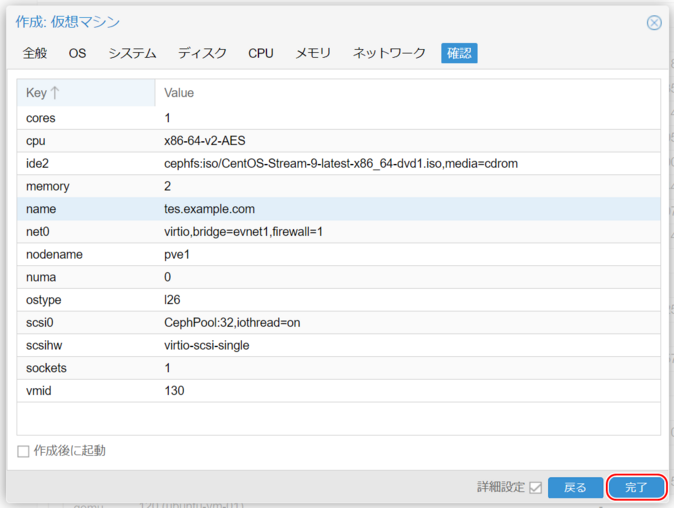

9.設定を確認する

入力内容を確認し、「完了」をクリックします。

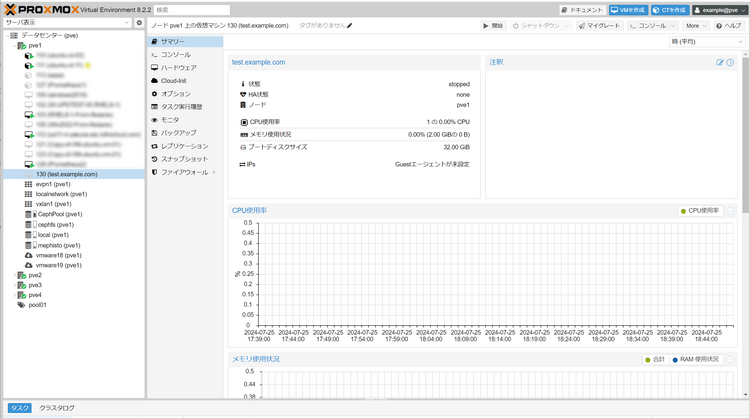

10.仮想マシン作成完了

「2:全般設定」で指定したノードの下に仮想マシンが作成されます。

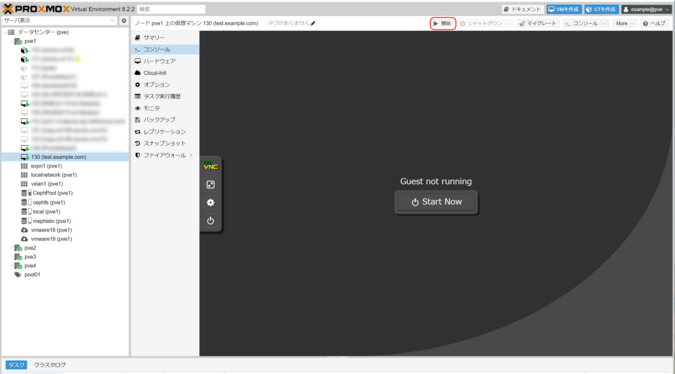

11.仮想マシンを起動する

次にゲストOSのインストールが必要です。「コンソール」タブに移動し「Start Now」ボタンを押して、仮想マシンを起動します。

仮想マシンを起動する前に、「ゲストOSインストール時のご注意」をご確認ください。仮想マシンの起動後は、インストーラーに従ってゲストOSのインストールを開始します。

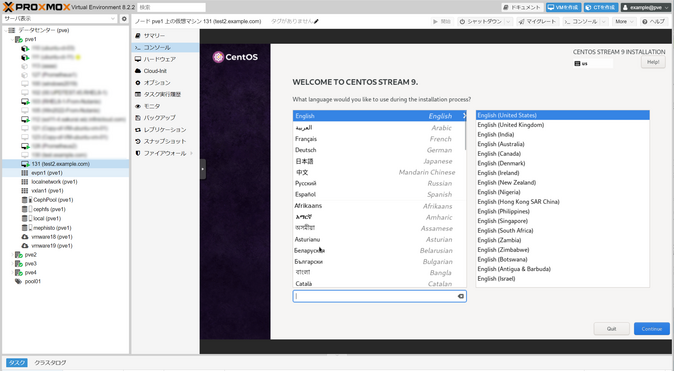

12.ゲストOSをインストールする

画面に従ってゲストOSをインストールします。